如何調用 Minimax 的 API

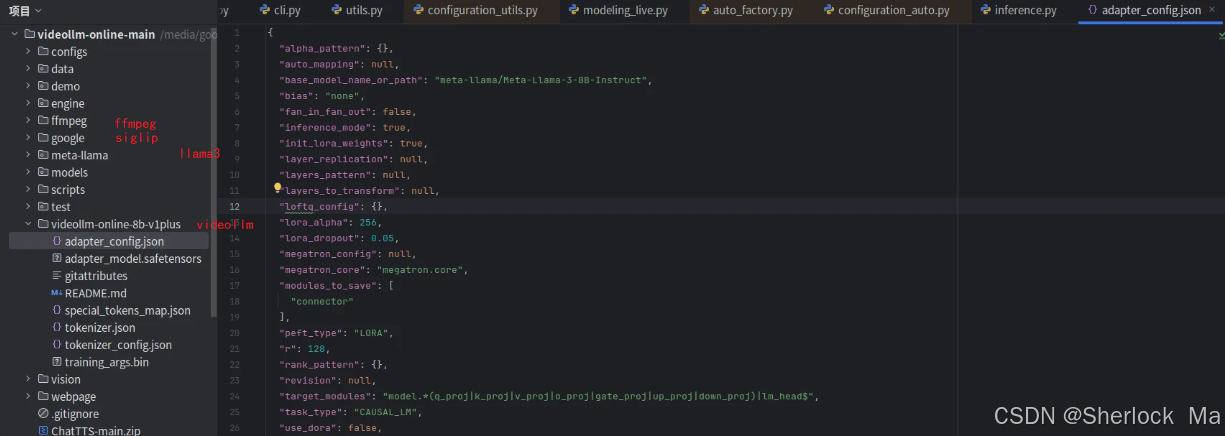

VideoLDM 的源碼結構復雜且嚴謹,主要分為視頻處理、數據輸入輸出、模型訓練與推理等模塊。源碼詳細記錄了如何將視頻流數據轉化為模型可理解的輸入,并通過精確的時間戳同步實現實時響應。以下是部分代碼示例,展示了視頻流的處理過程:

liveinfer = LiveInfer()

liveinfer.load_video('path_to_video')

frame_data = liveinfer.input_video_stream(current_time)從源碼中可以看出,VideoLDM 在數據處理方面具有高效的機制,能夠快速解析視頻幀并生成相應的文本描述。

VideoLDM 在數據處理上采用了先進的技術,能夠有效地將視頻數據轉化為模型輸入。其關鍵在于對視頻幀的高效編碼和時序信息的精確管理。模型通過CLIP ViT-L 編碼器提取視頻幀的特征嵌入,并將其與語言模型的輸入相結合,實現多模態信息的融合。

在輸入輸出機制上,VideoLDM 采用了以下策略:

ffmpeg_once(src_video_path, dst_video_path, fps=2, resolution=720)

frame_embeds = model.visual_embed(video_tensor)VideoLDM 的架構設計緊湊,主要包括圖像編碼器、MLP 和語言模型三大組件。每個組件在模型的整體運作中扮演著至關重要的角色。

圖像編碼器負責從視頻中提取視覺特征。VideoLDM 使用CLIP ViT-L 編碼器,這是一個經過大規模數據預訓練的模型,能夠高效地從視頻幀中提取豐富的視覺信息。

MLP 投影儀將提取的幀嵌入轉換為幀令牌,這些令牌與語言模型的輸入相結合,形成多模態信息的輸入序列。

語言模型使用的是Llama-2-7B-Chat,并結合LoRA進行調優,以提高模型的生成能力和效率。語言模型負責將多模態輸入轉化為自然語言輸出,生成對視頻內容的描述和回答。

VideoLDM 的訓練過程復雜而精細,涉及多種優化策略來提升模型的性能。其訓練方法主要包括以下幾個方面:

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

loss_fn = nn.CrossEntropyLoss()

for epoch in range(num_epochs):

for batch in dataloader:

optimizer.zero_grad()

outputs = model(batch['inputs'])

loss = loss_fn(outputs, batch['targets'])

loss.backward()

optimizer.step()在推理過程中,VideoLDM 通過優化的KV Cache和并行處理技術實現了高效的實時響應。模型能夠根據視頻幀的輸入,動態生成與上下文相關的描述和回答。

為了提高推理精度,VideoLDM 在預測EOS(對話結束)時引入了閾值校正機制,確保模型僅在必要時終止對話。

KV Cache 是一種緩存機制,能夠有效地存儲和重用過去的計算結果,從而加速后續的推理過程。

outputs = model(inputs_embeds=inputs_embeds, use_cache=True, past_key_values=past_key_values)VideoLDM 在多項基準測試中表現出色,其在速度、準確性和內存效率方面均優于現有模型。具體評估結果顯示,VideoLDM 在處理復雜視頻場景時,能夠保持穩定的性能,并提供高質量的實時描述。

答:VideoLDM 通過結合圖像編碼器、MLP 和語言模型,實時處理視頻幀并生成描述。

答:可以通過調整學習率、優化模型參數以及使用更高效的數據處理機制來提升性能。

答:VideoLDM 適用于流媒體視頻分析、智能監控和實時互動等場景。

答:可以通過優化KV Cache 和并行處理技術來減少推理延遲。

答:VideoLDM 的源碼可在GitHub上獲取,具體地址為 VideoLDM 源碼。