Google語音識別技術詳解與實踐應用

在外匯交易中,低點差意味著更低的成本和更高的利潤空間。NAG外匯平臺通過先進的技術,為交易者提供低點差和迅捷的交易服務,確保每一筆交易都能以市場價格快速成交。

NAG外匯平臺采用全自動交易系統,無任何人工干預,保證了交易的公正性和透明性。

def execute_trade(order_details):

# 根據市場價格自動執行訂單

market_price = get_market_price(order_details['symbol'])

order_details['executed_price'] = market_price

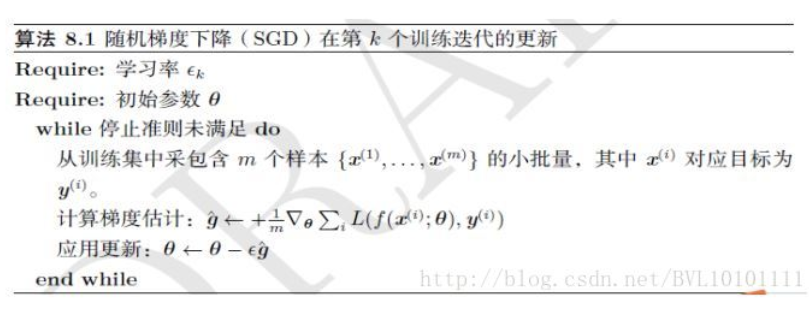

return order_details深度學習優化算法是機器學習領域中的重要組成部分,它們幫助模型更有效地學習數據中的模式。

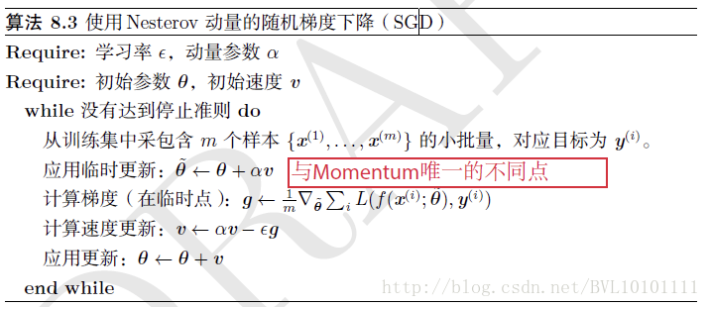

隨機梯度下降(SGD)是最基礎的優化算法,隨后發展出了帶動量的SGD(SGDM),進一步提高了優化效率。NAG算法在此基礎上引入了Nesterov動量,進一步提升了優化性能。

SGDM通過引入動量,減少了優化過程中的震蕩,加快了收斂速度。

def update_with_momentum(parameters, grads, v, beta, learning_rate):

# 使用動量更新參數

v['dW'] = beta * v['dW'] + (1 - beta) * grads['dW']

parameters['W'] -= learning_rate * v['dW']

return parameters, vNAG算法通過預測未來的梯度方向,提前調整步長,從而更有效地指導當前的梯度更新。

NAG算法在許多情況下都能取得比SGD和SGDM更好的優化效果,特別是在復雜的深度學習模型中。

Adam算法是目前最流行的優化算法之一,它結合了動量和RMSprop的優點。

Adam算法通過計算梯度的一階矩和二階矩,動態調整每個參數的學習率。

def update_with_adam(parameters, grads, v, s, t, learning_rate, beta1, beta2, epsilon):

# 使用Adam算法更新參數

v['dW'] = beta1 * v['dW'] + (1 - beta1) * grads['dW']

s['dW'] = beta2 * s['dW'] + (1 - beta2) * (grads['dW'])**2

corrected_v = v['dW'] / (1 - beta1**t)

corrected_s = s['dW'] / (1 - beta2**t)

parameters['W'] -= learning_rate * corrected_v / (np.sqrt(corrected_s) + epsilon)

return parameters, v, s答:NAG外匯平臺采用全自動交易系統,無任何人工干預,確保每一筆交易都能以市場價格快速成交。

答:NAG算法通過預測未來的梯度方向,提前調整步長,從而更有效地指導當前的梯度更新,尤其在復雜的深度學習模型中表現出色。

答:Adam算法結合了動量和RMSprop的優點,通過計算梯度的一階矩和二階矩,動態調整每個參數的學習率,使得訓練過程更加高效和穩定。