豆包 Doubao Image API 價格全面解析

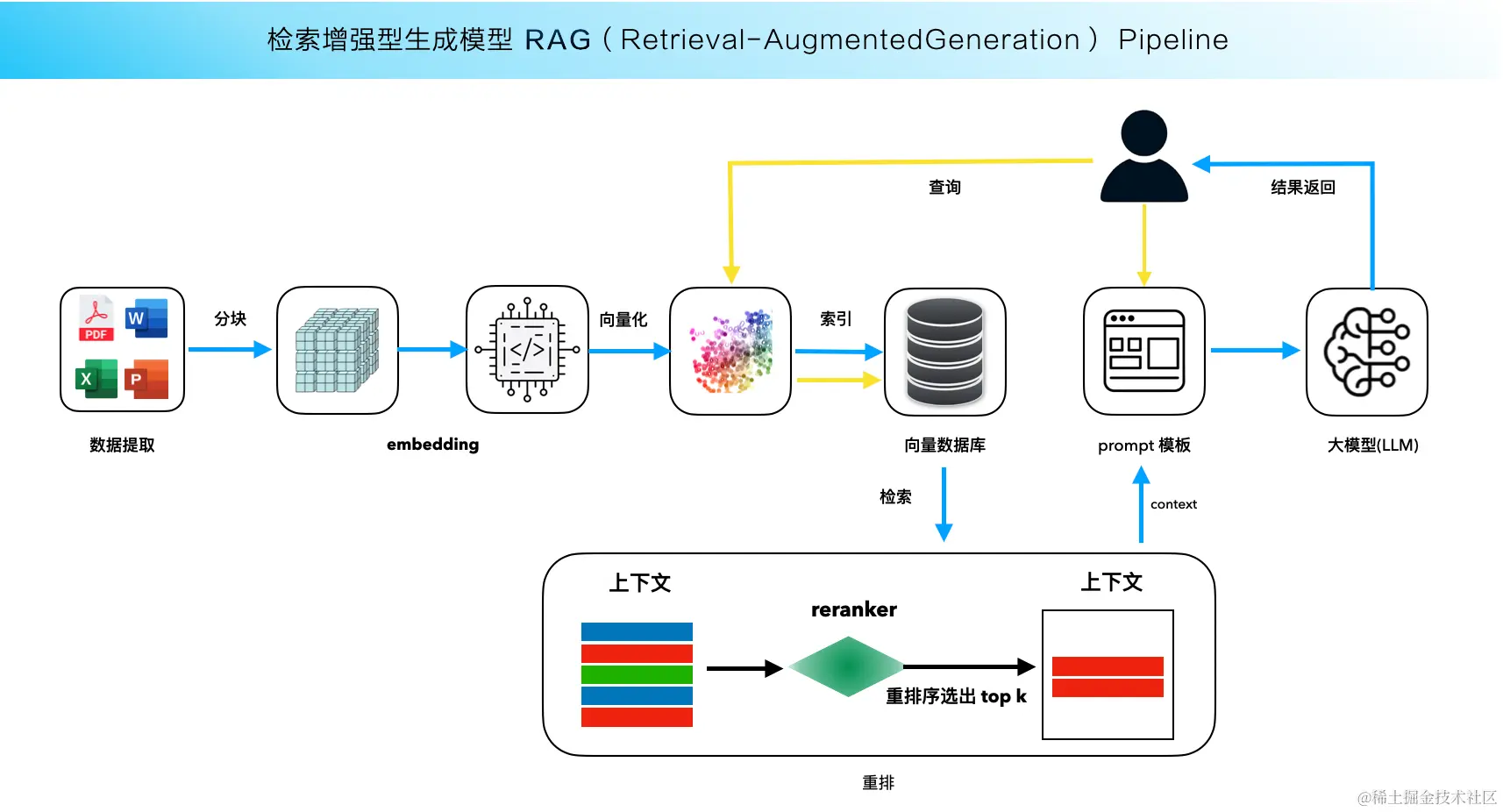

RAG(檢索增強生成)技術是一種結合信息檢索與語言生成的先進方法。它通過動態訪問外部知識庫,來增強語言模型的生成能力。RAG技術在處理開放域問題時,能夠克服傳統模型的信息容量限制和時效性不足,為用戶提供更為精準的答案。

在RAG的框架下,一個大型語言模型如Qwen2.5可以被理解為一個可以隨時查詢的“超級知識庫”。這種架構不僅擴大了模型的知識范圍,還增強了其在特定領域的準確性和時效性。對于需要實時信息和專業化知識的應用場景,如醫療咨詢、法律意見等,RAG提供了理想的解決方案。

Ollama是一個強大的工具,專門為大型語言模型(LLM)提供支持。它并不是一個LLM,而是一個能夠在本地環境中運行、測試和部署這些模型的平臺。Ollama的使用極大地方便了開發人員,尤其是在需要快速迭代和測試模型的情況下。

通過Ollama,用戶可以在本地機器上輕松部署Qwen2.5等大模型。其安裝過程簡便,只需通過命令行即可完成模型下載和運行。Ollama還支持多種操作系統,如Windows、Mac和Linux,使得它在不同的開發環境中都能被廣泛應用。

ollama install

ollama run qwen2.5-coder:7b

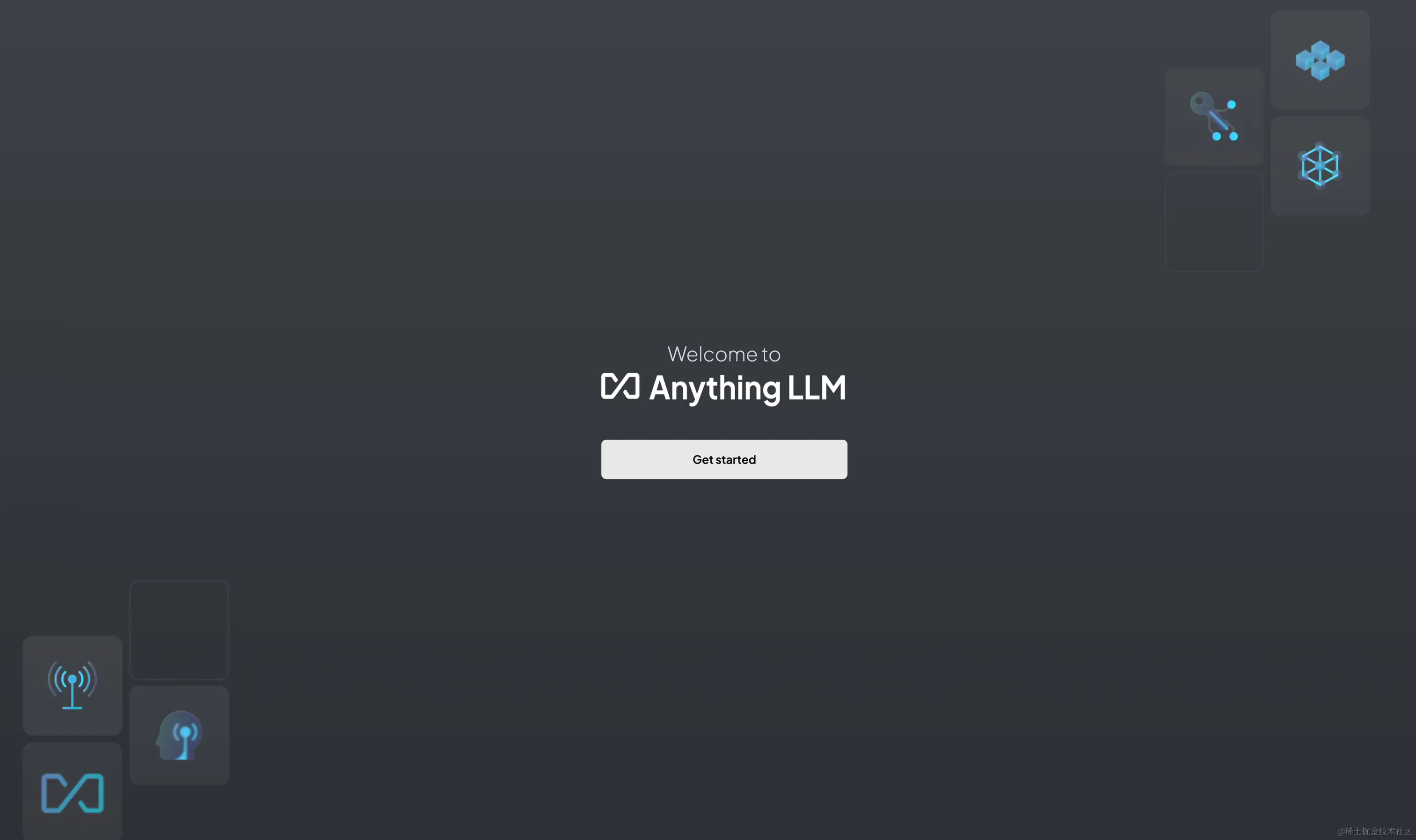

AnythingLLM是一個框架,旨在將語言模型與本地知識庫相結合,創建一個個性化的問答系統。它支持多種數據格式的輸入,包括PDF和Word文檔,甚至是網頁鏈接,極大地豐富了知識庫的內容來源。

在部署過程中,用戶可以選擇不同的模型和向量數據庫來優化性能。AnythingLLM的易用性使其成為構建本地知識庫的理想選擇,特別是在需要頻繁更新和管理大量數據的場景中。

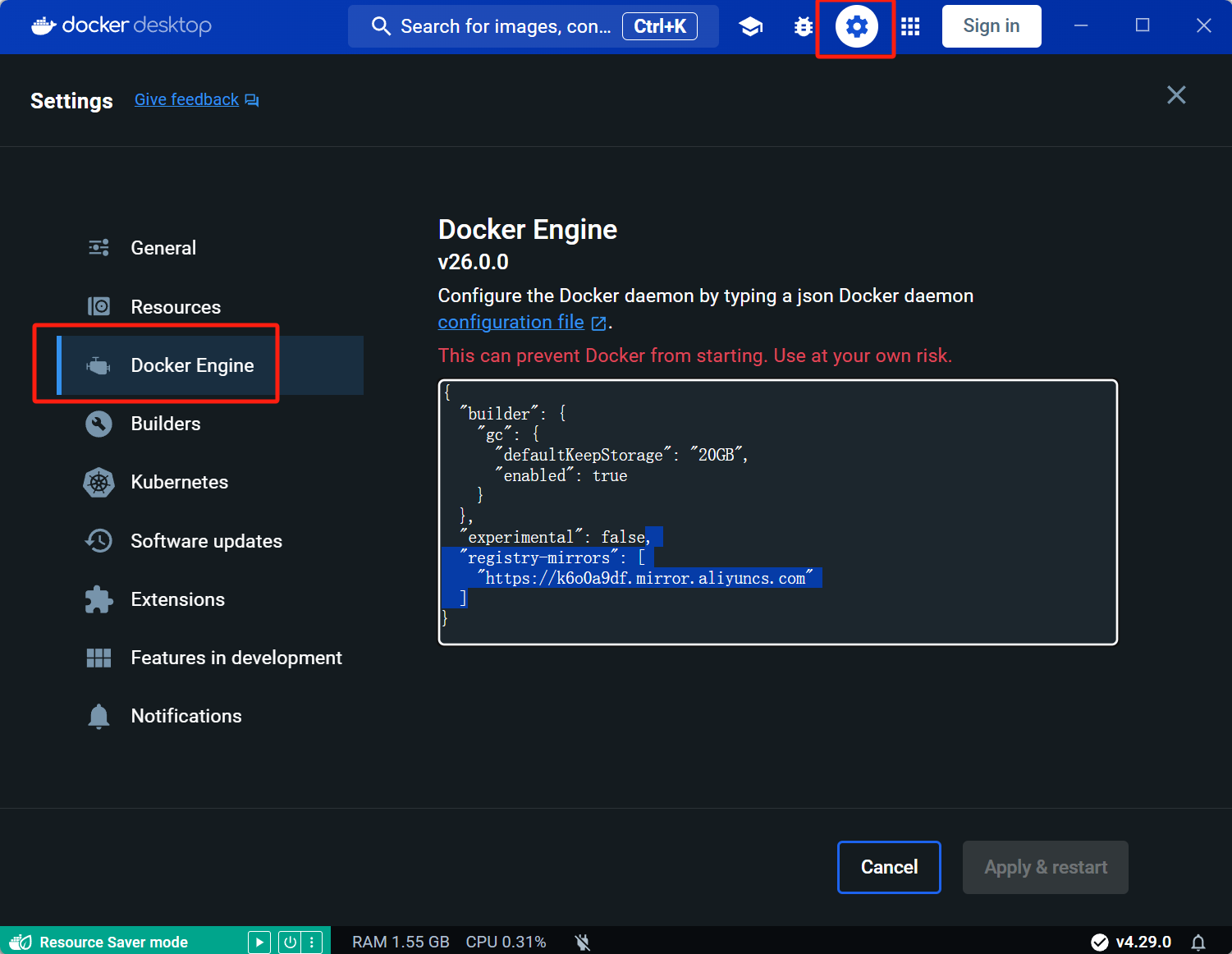

在開始搭建本地知識庫之前,確保你的開發環境已準備就緒。這里以Windows系統為例,首先需要啟用虛擬化功能,如Hyper-V和WSL子系統。這些功能為Docker的順利運行提供了必要的支持。接下來,安裝并配置Docker,確保鏡像源的設置能夠加速下載。

完成環境準備后,可以啟動AnythingLLM框架。首先,下載相關的Docker鏡像,然后通過命令行啟動框架。此時,你需要配置模型的API地址和所使用的大模型類型,這里選擇使用Ollama提供的Qwen2.5。

docker pull mintplexlabs/anythingllm

$env:STORAGE_LOCATION="$HOMEDocumentsanythingllm";

docker run -d -p 3001:3001

--cap-add SYS_ADMIN

-v "$env:STORAGE_LOCATION:/app/server/storage"

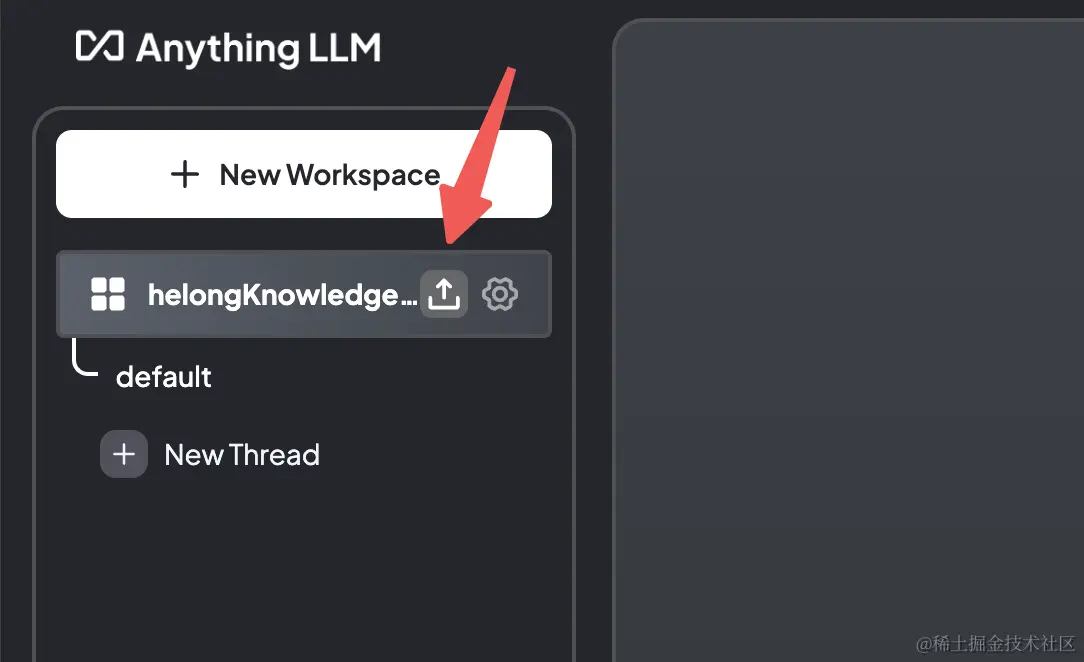

mintplexlabs/anythingllm;在AnythingLLM的工作界面中,你可以創建一個新的工作區并上傳你的數據。支持的格式包括txt、pdf和docx等。上傳完成后,系統將自動進行向量化處理,并將數據存儲到向量數據庫中。

答:選擇模型時,應根據應用場景的具體需求考慮模型的語言支持、參數規模和推理能力。對于需要復雜推理和代碼生成的場景,Qwen2.5-Coder是一個不錯的選擇。

答:RAG技術的主要優勢在于其靈活性和準確性。通過動態接入外部資源,RAG能夠提供實時更新的信息,提升問答系統的準確性和相關性。

答:通過在本地部署知識庫系統,數據不需要上傳到第三方服務器,極大地降低了數據泄露的風險。同時,定期更新和備份數據也是確保數據安全的重要措施。

答:Ollama支持Windows、Mac和Linux操作系統,這使得開發人員可以在各種環境中輕松部署和測試模型。

答:AnythingLLM提供了簡單的界面來管理數據。用戶可以上傳多種格式的文件,并通過向量化處理將其納入知識庫中,方便后續的檢索和問答。