實時航班追蹤背后的技術:在線飛機追蹤器的工作原理

批量梯度下降法使用整個訓練數據集來計算梯度,因此每次迭代的計算開銷較大,但其優點是每次更新方向較為準確。適用于數據集較小的情況。

隨機梯度下降法每次僅使用一個樣本來計算梯度,因此計算速度較快,適合大規模數據集。其缺點是收斂過程中可能會出現較大波動。

小批量梯度下降法結合了批量和隨機梯度下降法的優點,同時使用多個樣本來計算梯度,既提高了計算效率,又減少了波動。

梯度下降法在機器學習中有廣泛的應用,包括線性回歸、邏輯回歸和神經網絡的訓練。

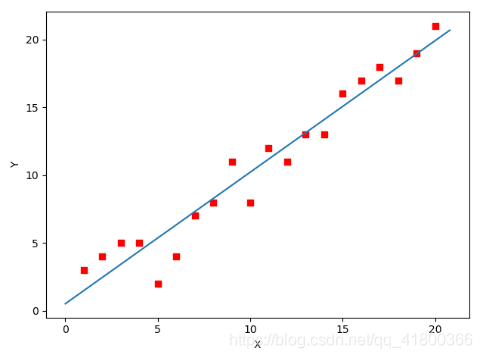

線性回歸模型通過最小化損失函數來擬合數據。梯度下降法通過調整模型參數,使得損失函數達到最小值,從而找到最佳擬合。

import numpy as np

X = np.array([[1, 1], [1, 2], [2, 2], [2, 3]])

y = np.dot(X, np.array([1, 2])) + 3

theta = np.zeros(2)

learning_rate = 0.01

for _ in range(1000):

gradient = X.T.dot(X.dot(theta) - y) / len(y)

theta -= learning_rate * gradient

print(f"Optimal parameters: {theta}")

邏輯回歸用于二分類問題,通過最大化似然函數來估計模型參數。梯度下降法通過最小化負對數似然函數實現參數估計。

神經網絡通過反向傳播算法進行訓練,梯度下降法用于更新網絡中的權重和偏置。

調優是提高梯度下降法性能的重要步驟,主要包括學習率的選擇和特征歸一化。

學習率決定了每次迭代的步伐,過大可能導致震蕩,過小則收斂緩慢。常用的方法是使用自適應學習率算法,如AdaGrad、RMSProp等。

特征歸一化可以加快收斂速度,常用的方法有標準化和歸一化。

以下是一個使用Python實現梯度下降法的示例代碼。

import numpy as np

theta = np.array([0.0, 0.0])

learning_rate = 0.01

X = np.array([[1, 1], [1, 2], [2, 2], [2, 3]])

y = np.dot(X, np.array([1, 2])) + 3

for _ in range(1000):

gradient = np.dot(X.T, np.dot(X, theta) - y) / len(y)

theta -= learning_rate * gradient

print(f"Optimal parameters: {theta}")梯度下降法是機器學習中一個重要的優化工具,通過不斷迭代優化模型參數,可以有效降低損失函數值,提高模型的預測能力。盡管存在一些缺點,如需調整學習率和可能陷入局部最優解,但通過合理的調優和改進,梯度下降法仍然是一個強大而靈活的優化方法。

問:梯度下降法可以用于所有的優化問題嗎?

問:如何選擇合適的學習率?

問:梯度下降法如何避免陷入局部最優解?