API是什么?深入解析API及其應(yīng)用

在全連接層中,輸入數(shù)據(jù)通過權(quán)重矩陣進(jìn)行線性變換,然后通過激活函數(shù)進(jìn)行非線性變換,從而實(shí)現(xiàn)對(duì)輸入數(shù)據(jù)的復(fù)雜映射。這使得全連接層能夠?qū)斎霐?shù)據(jù)進(jìn)行特征提取和模式識(shí)別。

全連接層的核心在于其權(quán)重矩陣。假設(shè)輸入為一個(gè)向量 ( x ),權(quán)重矩陣為 ( W ),則輸出 ( y ) 可以表示為:

import numpy as np

def fully_connected_layer(x, W, b):

return np.dot(W, x) + b其中,( b ) 為偏置向量。這個(gè)線性變換過程可以幫助模型捕捉輸入數(shù)據(jù)的線性關(guān)系。

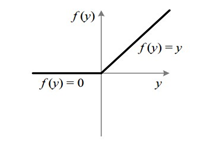

在全連接層中,激活函數(shù)可以提供非線性能力,使得網(wǎng)絡(luò)能夠擬合復(fù)雜的函數(shù)關(guān)系。常見的激活函數(shù)包括 ReLU、sigmoid 和 tanh。

激活函數(shù)的選擇對(duì)模型的性能有很大影響,需根據(jù)具體任務(wù)進(jìn)行選擇。

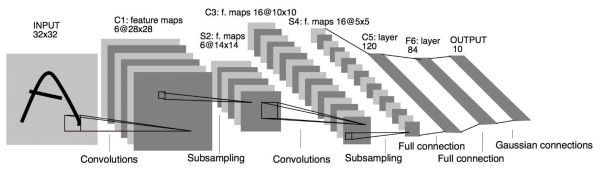

VGG網(wǎng)絡(luò)是一種經(jīng)典的深度卷積神經(jīng)網(wǎng)絡(luò),它在最后幾層使用了多個(gè)全連接層來進(jìn)行分類任務(wù)。例如,在 VGG-16 中,最后一層卷積的輸出為7x7x512,而全連接層的輸出則是一個(gè)4096維的向量。

這種設(shè)計(jì)使得 VGG 網(wǎng)絡(luò)能夠很好地提取圖像的高層語義特征,并進(jìn)行有效的分類。

ResNet引入了殘差連接(Residual Connection),并在某些版本中用全局平均池化(GAP)替代了全連接層,從而減少參數(shù)量并提升模型性能。

這種設(shè)計(jì)不僅提高了模型的訓(xùn)練速度,而且在某些任務(wù)上也提高了準(zhǔn)確性。

一種有效的減少全連接層參數(shù)量的方法是使用全局平均池化(Global Average Pooling,GAP)替代全連接層。這種方法不僅減少了參數(shù)量,還能提高特征的全局性。

正則化技術(shù)(如L2正則化、Dropout等)是防止過擬合的有效手段。通過在訓(xùn)練過程中引入懲罰項(xiàng),可以限制模型的復(fù)雜度,從而提高模型的泛化能力。

通過調(diào)整全連接層的層數(shù)和每層的神經(jīng)元數(shù)量,可以在模型復(fù)雜度和計(jì)算效率之間取得平衡。通常情況下,較少的神經(jīng)元和層數(shù)可以減少參數(shù)量,但可能會(huì)降低模型的表達(dá)能力。

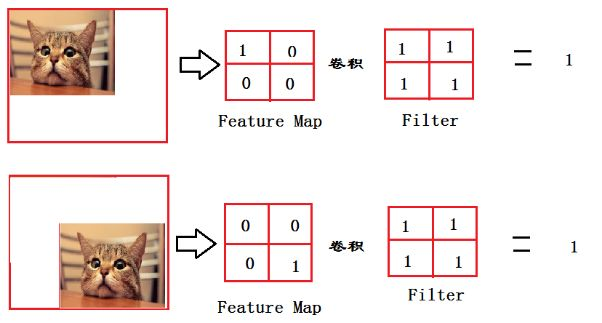

在圖像分類任務(wù)中,全連接層通常位于網(wǎng)絡(luò)的末端,負(fù)責(zé)將卷積層提取的特征進(jìn)行分類。以貓的分類任務(wù)為例,全連接層可以通過對(duì)輸入圖像的特征進(jìn)行加權(quán)求和,最終輸出一個(gè)概率值,表示圖像中包含某個(gè)類別的可能性。

在這個(gè)過程中,全連接層的作用就如同一個(gè)“決策者”,負(fù)責(zé)將前一層提取的復(fù)雜特征進(jìn)行整合,從而做出最終的判斷。

在自然語言處理(NLP)任務(wù)中,全連接層同樣發(fā)揮著重要作用。例如,在文本分類任務(wù)中,全連接層可以將前一層提取的文本特征進(jìn)行整合,并輸出分類結(jié)果。

在這種任務(wù)中,全連接層的設(shè)置(如層數(shù)、神經(jīng)元數(shù)量、激活函數(shù)等)需要根據(jù)具體任務(wù)需求進(jìn)行調(diào)整,以達(dá)到最佳效果。

全連接層是神經(jīng)網(wǎng)絡(luò)中一種基本的層結(jié)構(gòu),特點(diǎn)是層中的每一個(gè)神經(jīng)元都與前一層的所有神經(jīng)元相連接。它常用于特征整合和分類任務(wù)。

卷積層主要用于局部特征提取,而全連接層用于全局特征整合。因此,卷積層通常放在網(wǎng)絡(luò)的前部,而全連接層通常放在后部,用于最終的分類或回歸任務(wù)。

可以通過使用正則化技術(shù)(如L2正則化、Dropout等)來減少過擬合。此外,適當(dāng)減少層數(shù)和神經(jīng)元數(shù)量,以及使用數(shù)據(jù)增廣等方法也有助于提高模型的泛化能力。

全連接層的參數(shù)量直接影響模型的復(fù)雜度和計(jì)算效率。過多的參數(shù)可能導(dǎo)致過擬合,而過少的參數(shù)可能導(dǎo)致模型表達(dá)能力不足。因此,需在參數(shù)量和模型性能之間取得平衡。

全局平均池化(GAP)可以減少模型的參數(shù)量,從而減少過擬合的風(fēng)險(xiǎn)。此外,GAP能夠提高特征的全局性,有助于提升模型在某些任務(wù)上的表現(xiàn)。

本文通過詳盡的例子和分析,幫助您理解全連接層在深度學(xué)習(xí)中的角色及其重要性。無論是在圖像處理還是自然語言處理任務(wù)中,全連接層都扮演著不可或缺的角色。

對(duì)比大模型API的內(nèi)容創(chuàng)意新穎性、情感共鳴力、商業(yè)轉(zhuǎn)化潛力

一鍵對(duì)比試用API 限時(shí)免費(fèi)