大模型RAG技術:從入門到實踐

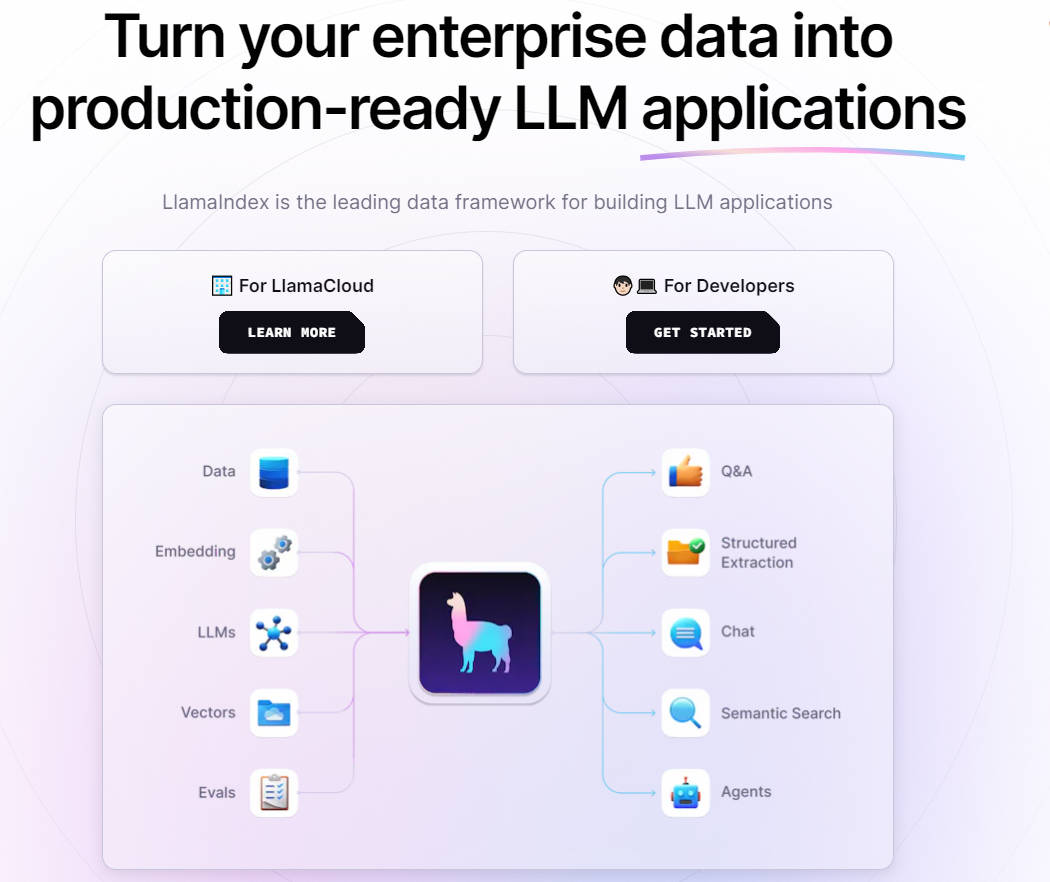

LlamaIndex是一個基于LLM的應用程序的數據框架,支持上下文增強。它提供了必要的抽象,便于攝取、構建和訪問私有或特定領域的數據,以實現更準確的文本生成。

LlamaIndex的核心功能包括數據連接器、數據結構、高級檢索/查詢界面以及與其他框架的集成。通過這些功能,用戶可以輕松地攝取和結構化數據,從而提高數據檢索的效率和準確性。

為了構建一個有效的RAG系統,首先需要攝取相關數據并建立索引。LlamaIndex支持多種數據格式和來源,如PDF、數據庫和API等。

import os

from llama_index import GPTVectorStoreIndex, SimpleDirectoryReader

documents = SimpleDirectoryReader('data').load_data()

index = GPTVectorStoreIndex.from_documents(documents)LlamaIndex支持向量存儲索引、樹索引、列表索引等多種數據結構形式,以滿足不同的檢索需求。通過對索引的優化,可以提高檢索的準確性和效率。

當實際答案不在知識庫中時,RAG 系統可能給出誤導性答案。為此,建議優化數據源和改進提示方式。

為了解決這一問題,可以重新排名檢索結果,或調整數據塊大小和相似度排名超參數。

通過優化檢索策略和微調嵌入模型,可以提高RAG系統的上下文整合能力。

Qwen1.5是一個中文LLM,提供了多種大小的基礎和聊天模型,支持32K上下文。通過與LlamaIndex結合,可以實現強大的RAG功能。

from llama_index.llms.huggingface import HuggingFaceLLM

llm = HuggingFaceLLM(model_name='qwen/Qwen1.5-4B-Chat', device_map='auto')通過LlamaIndex,用戶可以輕松構建基于本地知識庫的問答系統,實現高效的信息檢索與生成。

query_engine = index.as_query_engine()

response = query_engine.query("西安交大是由哪幾個學校合并的?")

print(response)通過結合LlamaIndex和Qwen1.5,我們能夠構建一個高效的RAG系統,實現準確、可靠的信息生成。這種方法不僅提升了生成內容的質量,也增強了系統的可用性和可擴展性。

問:LlamaIndex如何提高檢索的準確性?

問:RAG系統如何緩解幻覺問題?

問:如何將Qwen1.5與LlamaIndex結合使用?

通過本文的探討,希望能夠為讀者提供關于RAG系統與LlamaIndex的深入理解,并激勵更多人參與到該領域的開發與應用中。