通過本地部署,Kimi本地知識庫能夠快速響應(yīng)用戶的搜索請求,并支持復雜的自然語言查詢,使得用戶可以更高效地獲取所需信息,而不必擔心隱私泄露。

為了在本地搭建Kimi知識庫,首先需要使用Docker進行部署。Docker的優(yōu)勢在于其容器化技術(shù),可以輕松實現(xiàn)軟件的快速部署和管理。

在開始之前,請確保您的計算機上已經(jīng)安裝了Docker。如果尚未安裝,可以通過訪問Docker官方網(wǎng)站下載并安裝Docker Desktop。安裝過程中,確保啟用了 "Use WSL 2 instead of Hyper-V (recommended)" 選項。

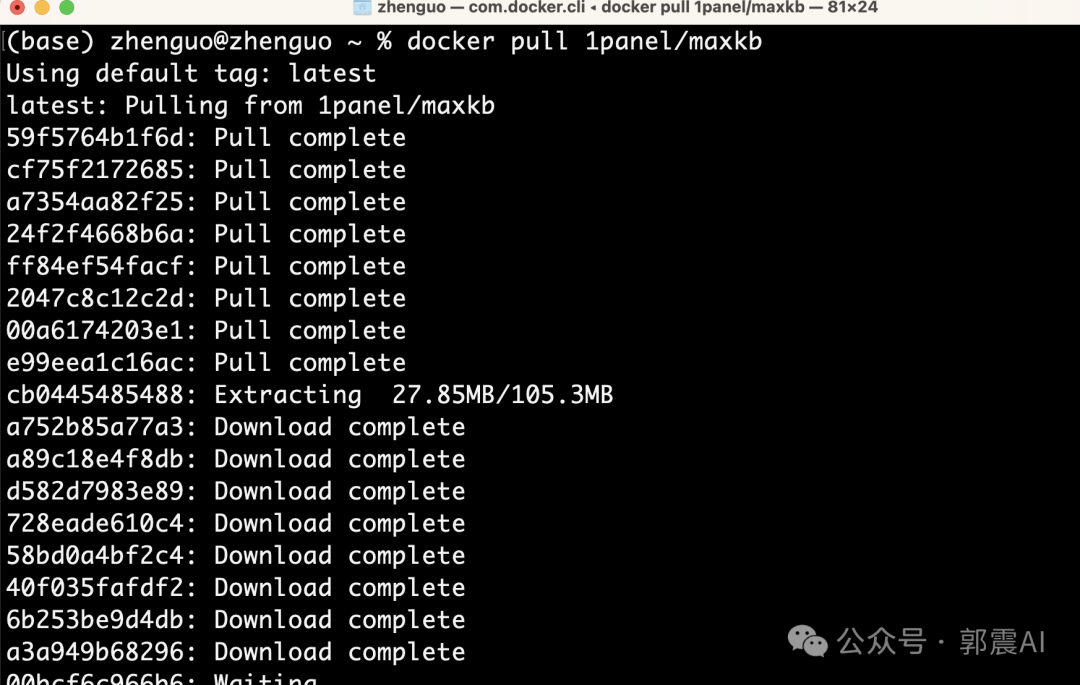

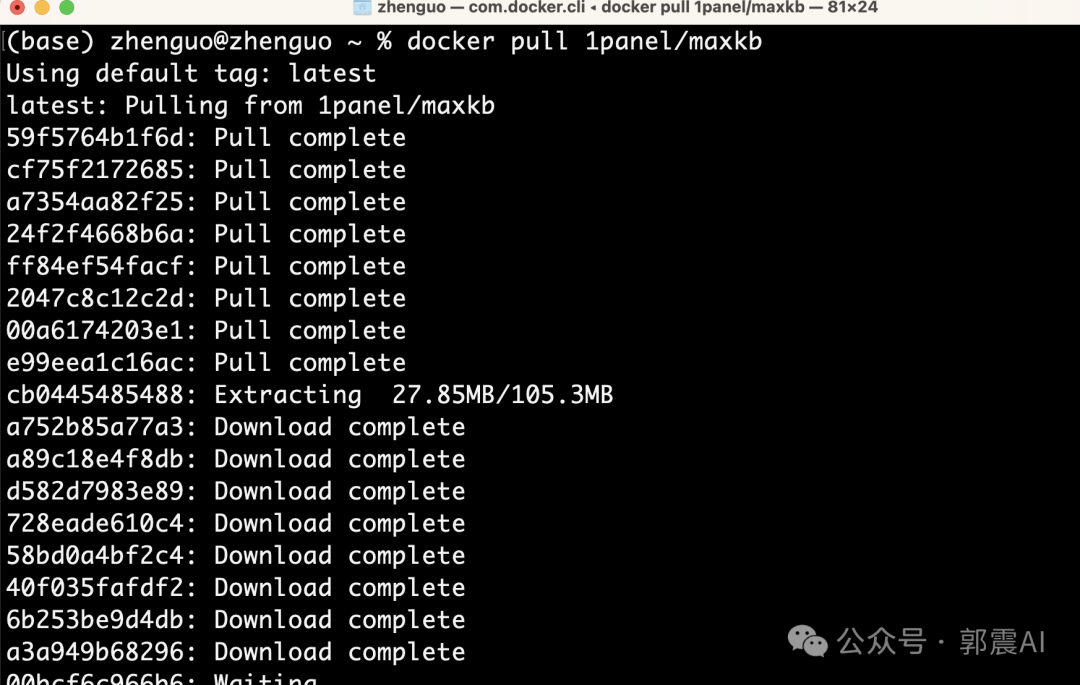

安裝好Docker后,打開終端并輸入以下命令以下載Kimi的Docker鏡像:

docker pull kimi/maxkb下載完成后,您將擁有一個Kimi知識庫的Docker鏡像,接下來需要為其創(chuàng)建一個容器。

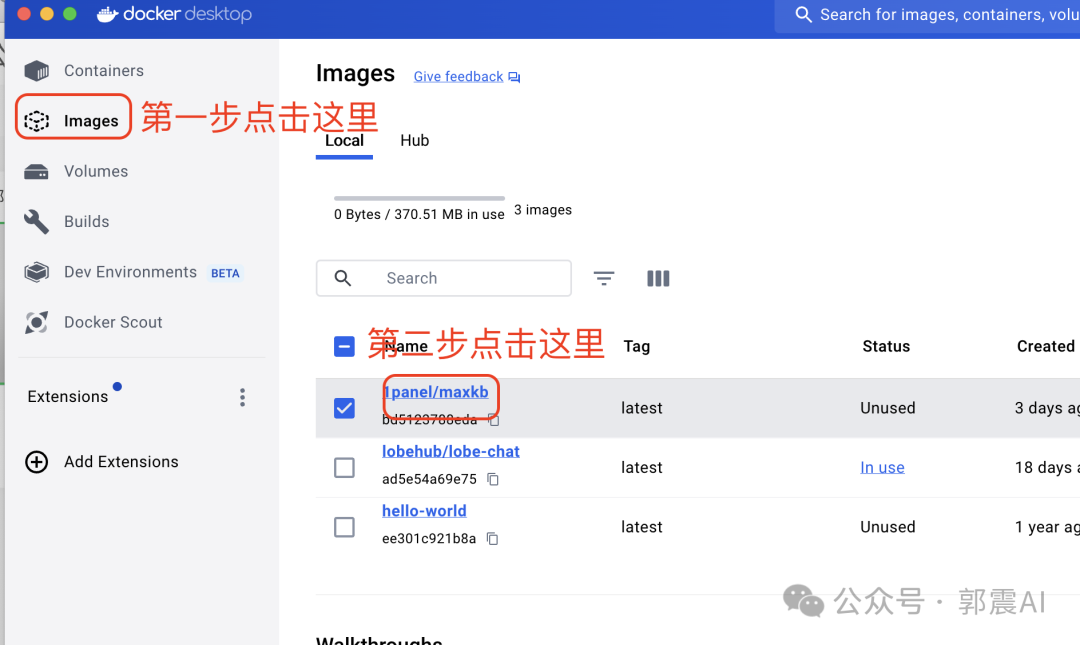

在成功下載鏡像后,您需要通過Docker的圖形界面來創(chuàng)建一個運行的容器。

容器成功運行后,您可以通過瀏覽器訪問Kimi知識庫的界面。打開瀏覽器,輸入以下地址:

http://127.0.0.1:8080初次登錄需要賬號和密碼,您可以通過關(guān)注相關(guān)公眾號獲取。

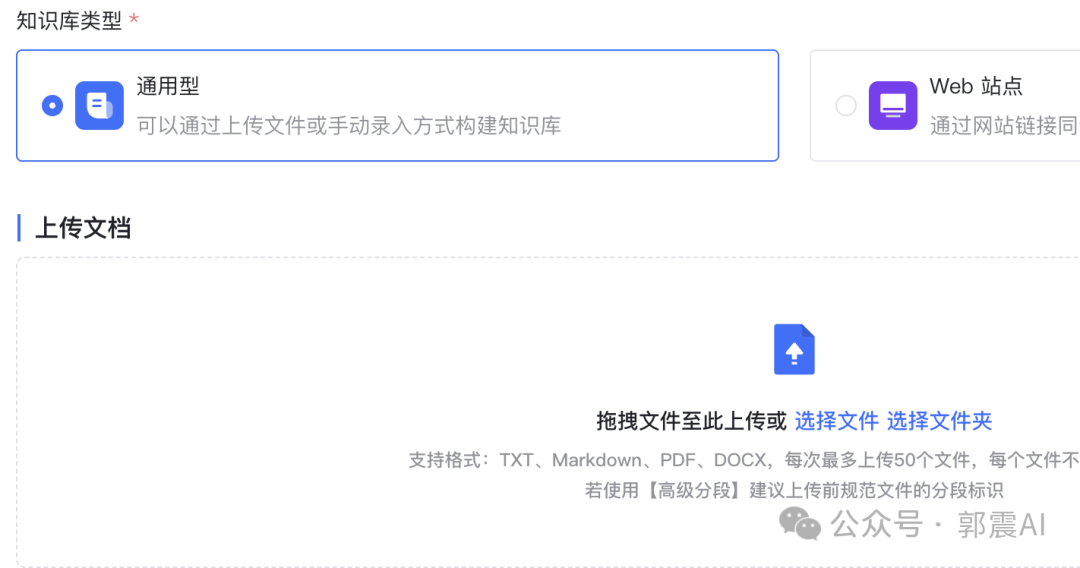

在成功登錄Kimi后,您可以開始創(chuàng)建和管理您的知識庫。Kimi支持多種數(shù)據(jù)格式和文檔類型,包括txt、word、pdf、ppt等。

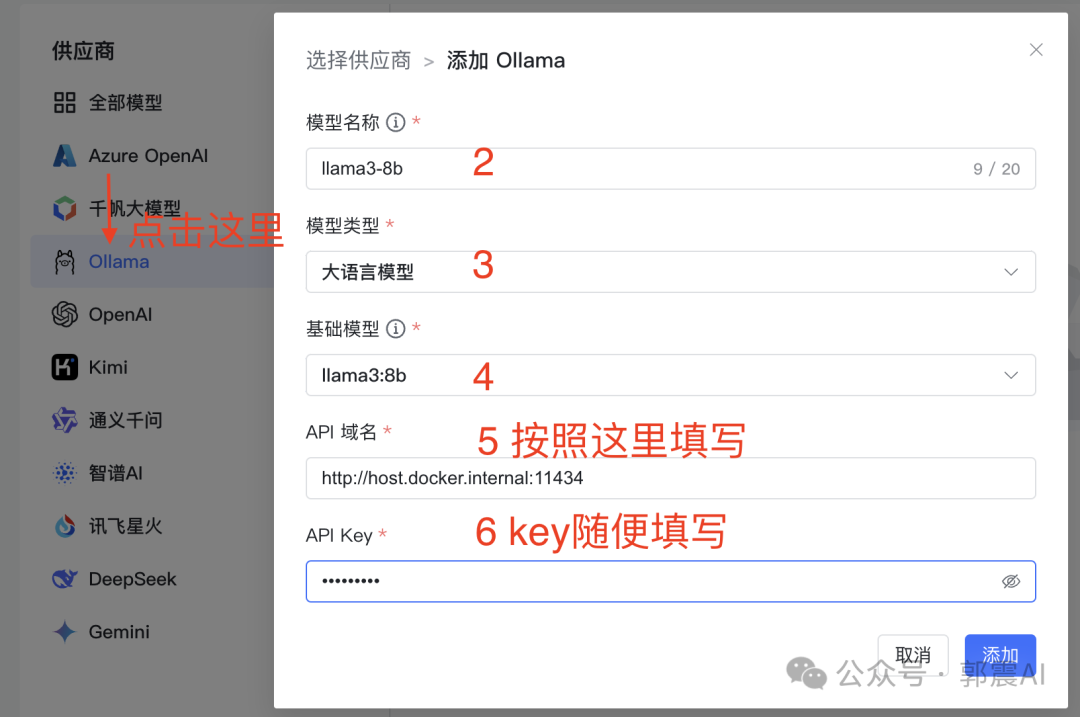

Kimi知識庫支持多種大語言模型,如GPT、Llama3等。通過在本地配置這些模型,可以顯著提升知識庫的智能化水平。

ollama run llama3

接下來,我們將創(chuàng)建一個應(yīng)用,以便將大語言模型與知識庫結(jié)合使用。

使用Kimi本地知識庫的優(yōu)勢在于數(shù)據(jù)的安全性和處理的效率。所有的操作都在本地完成,確保數(shù)據(jù)不會泄露。同時,得益于大語言模型的支持,Kimi可以實現(xiàn)高效的自然語言處理和智能問答功能。

Kimi本地知識庫為用戶提供了一個安全、高效的文檔管理和智能問答平臺。通過本地部署和大語言模型的集成,用戶可以在保護數(shù)據(jù)隱私的同時,享受到現(xiàn)代化的知識管理和搜索體驗。

Kimi本地知識庫是一種在本地運行的知識管理系統(tǒng),利用大語言模型進行文檔搜索和問答,確保數(shù)據(jù)的隱私和安全。

您需要訪問Docker官方網(wǎng)站下載Docker Desktop并進行安裝,安裝時需啟用WSL 2選項。

Kimi支持多種大語言模型,如GPT、Llama3等,這些模型可以在本地配置使用。

所有數(shù)據(jù)都存儲在本地,并且不需要通過云端傳輸,因此可以確保數(shù)據(jù)的隱私性。

您可以通過關(guān)注相關(guān)公眾號并回復指定關(guān)鍵詞獲取登錄信息。