DeepSeek Janus-Pro 應用代碼與圖片鏈接實踐

在 ModelScope 上構建私人 AI 助手的流程相對簡單,主要包括模型選擇、訓練、部署和優化幾個步驟。在以下部分中,我們將詳細介紹這些步驟。

在構建私人 AI 助手時,選擇合適的模型是至關重要的。ModelScope 提供了多種預訓練模型,涵蓋了從自然語言處理到計算機視覺的多種應用領域。

用戶可以根據自己的需求選擇合適的模型,并在其基礎上進行微調和優化。

在選擇好模型后,用戶可以使用 ModelScope 提供的工具進行模型訓練和微調。平臺支持多種訓練策略,包括全參數微調和部分參數微調。

from modelscope import AutoModelForCausalLM, AutoTokenizer

device = "cuda"

model = AutoModelForCausalLM.from_pretrained(

"qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4")在訓練過程中,用戶可以根據需要調整模型的超參數,以獲得更好的性能表現。

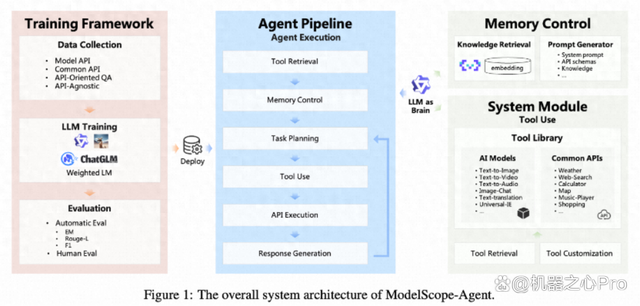

ModelScope-Agent 是 ModelScope 平臺提供的一個通用的 AI 助手框架,具有靈活的定制能力和強大的功能支持。用戶可以利用該框架快速構建適合不同需求的智能助手。

ModelScope-Agent 的架構設計靈活,支持多種模塊的組合使用,包括記憶控制、工具調用和對話管理等。

使用 ModelScope-Agent,用戶可以輕松實現多輪對話功能,使助手能夠進行更自然和連貫的對話。

def multi_dialogue():

model, tokenizer = initialize_dialogue()

dialogue_state = {"history": [], "current_round": 0}

while True:

user_input = input("請輸入您的問題或指令,或輸入 'quit' 以結束對話:")

if user_input.lower() == "quit":

break

response = generate_response(model, tokenizer, user_input, dialogue_state["history"])

print(f"助手回復:{response}")ModelScopeGPT 是基于 ModelScope 開發的智能助手,廣泛應用于文本生成、翻譯和信息抽取等領域。通過集成多種 AI 模型,ModelScopeGPT 能夠在多個任務中提供高效的解決方案。

用戶可以通過 ModelScope 平臺提供的 API 調用 ModelScopeGPT,實現多種智能任務的自動化處理。

response, history = model.chat(tokenizer, "你好", history=None)

print(response)ModelScope 在 AI 模型的開發和應用中具有顯著的優勢,不僅提供了豐富的模型資源,還支持多種應用場景的智能化解決方案。

隨著 AI 技術的不斷發展,ModelScope 將繼續擴展其模型庫和功能,支持更多的應用場景和用戶需求。

阿里通義 ModelScope 為開發者提供了一個強大的平臺,可以輕松創建和部署私人 AI 助手。通過利用 ModelScope 的豐富資源和工具,用戶可以快速實現智能化的應用,滿足多種場景的需求。

問:ModelScope 如何支持多輪對話?

問:如何開始使用 ModelScope?

問:ModelScope 支持哪些編程語言?

通過本文的介紹,希望您對阿里通義 ModelScope 私人 AI 助手有更深入的了解,并能在開發中加以應用。