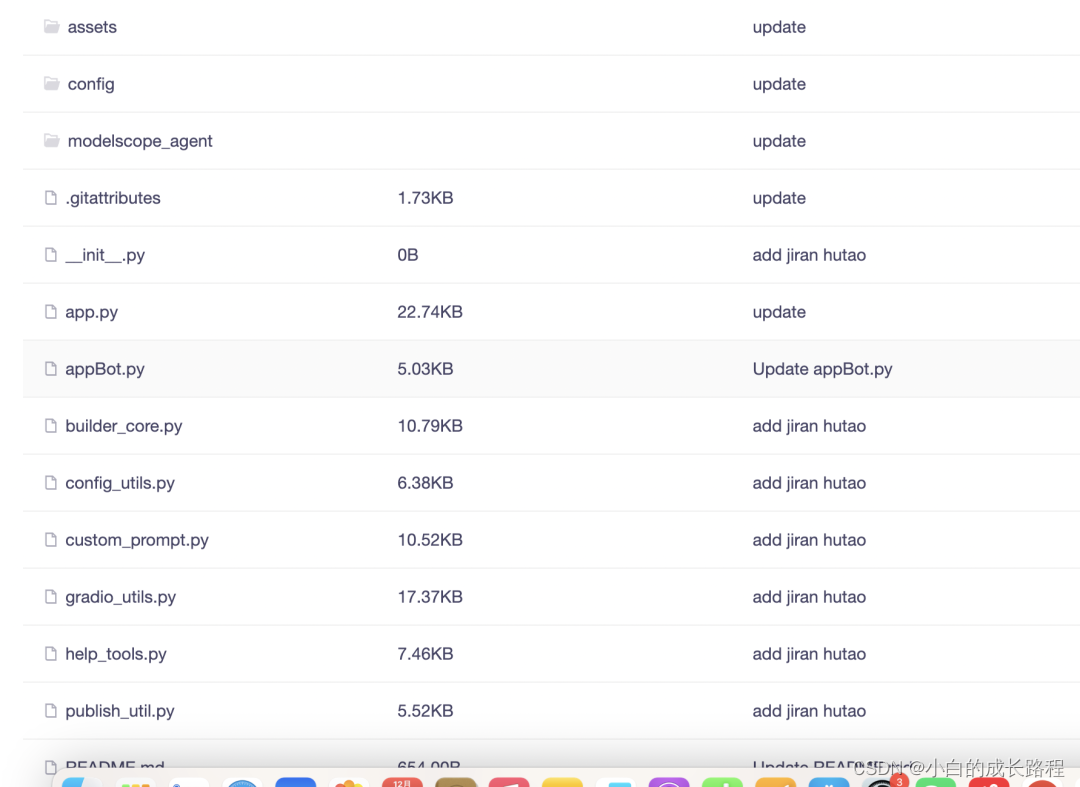

DeepSeek Janus-Pro 應用代碼與圖片鏈接實踐

要在 ModelScope 上下載模型,用戶需要通過平臺提供的API接口進行操作。以下是一個下載模型的代碼示例:

from modelscope.models import Model

model = Model.from_pretrained('thomas/m3e-base')這樣即可將模型自動下載到本地緩存目錄中,方便后續調用和使用。

在下載模型時,用戶需確保本地環境已安裝必要的依賴庫,并根據需求選擇合適的模型版本。此外,合理規劃本地存儲空間,避免因模型文件過大導致的磁盤空間不足問題。

ModelScope 的安裝相對簡單,用戶可以通過 pip 命令直接安裝:

pip install modelscope對于特定領域的模型需求,還可以安裝相關領域的依賴:

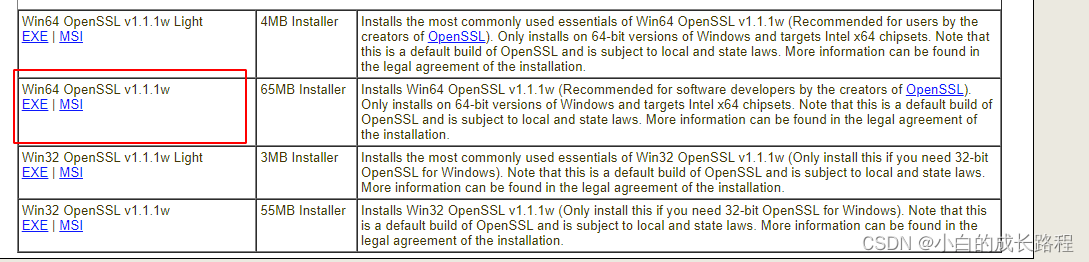

pip install modelscope[nlp] -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html安裝完成后,需要進行環境配置,如設置環境變量和安裝必要的運行時庫。特別是對于 Windows 用戶,需要注意 OpenSSL 版本的匹配,以確保代碼的正常運行。

使用 ModelScope 進行模型推理非常直觀。以下是一個簡單的推理代碼示例:

from modelscope import AutoModelForCausalLM, AutoTokenizer

device = "cuda"

model = AutoModelForCausalLM.from_pretrained(

"qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4")

prompt = "給我一份上海旅游的旅行計劃"

text = tokenizer.apply_chat_template([

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

], tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(device)

response = model.generate(model_inputs.input_ids, max_new_tokens=512)

print(tokenizer.batch_decode(response, skip_special_tokens=True)[0])對于需要多輪對話的場景,可以通過以下代碼實現:

def multi_dialogue():

model, tokenizer = initialize_dialogue()

dialogue_state = {"history": [], "current_round": 0}

while True:

user_input = input("請輸入您的問題或指令,或輸入 'quit' 以結束對話:")

if user_input.lower() == "quit":

break

dialogue_state["history"].append({"role": "user", "content": user_input})

prompt = "".join([message["content"] for message in dialogue_state["history"]])

response = generate_response(model, tokenizer, prompt, dialogue_state["history"])

dialogue_state["history"].append({"role": "system", "content": response})

dialogue_state["current_round"] += 1

print(f"助手回復:{response}")ModelScope 提供了豐富的自然語言處理模型,涵蓋文本分類、情感分析、翻譯等多個領域。開發者可以根據項目需求選擇合適的模型進行應用,快速實現復雜的NLP任務。

在計算機視覺領域,ModelScope 提供了多種預訓練模型,如圖像分類、目標檢測和圖像生成等。這些模型經過優化和驗證,能夠以較高的精度和效率處理視覺數據。

對于 Windows 用戶,環境搭建可能需要額外的步驟,如安裝 OpenSSL 和配置環境變量。以下是配置 OpenSSL 的步驟:

openssl version在使用 ModelScope 的過程中,可能會遇到一些常見問題。例如,OpenSSL 版本不匹配導致的錯誤可以通過更新安裝解決。對于其他問題,建議查閱 ModelScope 的官方文檔或社區支持。

ModelScope 主要支持 Python 語言,因為其 API 和庫是基于 Python 生態系統設計的。

確保下載適合操作系統版本的 OpenSSL 安裝包,并正確配置環境變量。如果問題依舊,建議檢查系統更新或聯系技術支持。

雖然 GPU 能夠加速模型的訓練和推理,但 ModelScope 也支持在 CPU 上運行。不過,性能可能會有所下降。

是的,ModelScope 支持用戶上傳自定義模型,并通過平臺提供的接口進行托管和調用。

可以訪問 ModelScope 的官方社區和 GitHub 倉庫,獲取最新的使用案例和用戶分享。

通過這篇文章,我們詳細探討了阿里通義 ModelScope 的應用和使用方法,希望能為有志于 AI 模型開發的讀者提供有價值的參考。